OpenAI增强安全团队 授予其董事会否决危险AI的权力 可直接否定

2023-12-20 14:01阅读(112)

北京时间12月19日,openai在官网当中宣布将会扩展内部的安全流程,来抵御一些有害的人工智能威胁,增加一个新的安全顾问小组,而这个小组将会在技术团队之上,可

北京时间12月19日,openai在官网当中宣布将会扩展内部的安全流程,来抵御一些有害的人工智能威胁,增加一个新的安全顾问小组,而这个小组将会在技术团队之上,可以直接向领导层提出一些建议,并且董事会会给安全顾问小组授予否决危险AI的一个权力,也就意味着安全小组是有直接性的权利处理认为有危险性的人工智能威胁。

在这一份公告当中,open AI是讨论了最新的一些框架问题,Open AI将会跟踪,评估,预测和防范现在逐渐强大的人工智能模型带来灾难性风险的一个流程,对于如何判定为灾难性的风险,open AI认为任何可能会导致经济损失或者说导致他人伤害死亡的风险,都会被称之为灾难性的风险,人工智能在快速发展的过程当中也一定会带来一些潜在的危险,对于open AI公司而言,肯定是想要控制好这些风险性,目前人工智能的功能性越发的全面,对于生活当中如果出现了一些无法判定的事情,可以交给人工智能来进行判定,人工智能会给出是否具有危险的相关指令,同时也会给出一些建议。

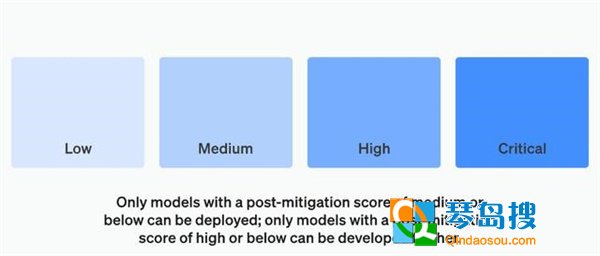

OpenAI的准备框架分成了不同的关键性要素,第一个要素是评估和打分,将会不断的去评估所有的模型,这样是能够对他们进行更好的打分,第二个要素是设定一个风险性的阈值,如果超过了这个阈值,将会被进行上报,第三个要素是监督技术工作以及安全的决策,所有的报告都可以发给领导层和董事会,让领导和董事会来进行决定,第四个要素是增加问责的制度,对于出现的任何问题,都需要有相关的人员来承担这个责任。

相关问答推荐

热点关注

OpenAI增强安全团队 授予其董事 市值差4.5倍 拼多多为啥能比京东 马云放不下田园牧歌:新农业品牌 罗永浩:东方甄选“去董化” 帮 重要合作 OpenAI准备付费使用出 小米汽车量产倒计时 雷军比许家 蔚来CEO李斌称全新行政旗舰轿车E 有2种交互方式 初探苹果Vision P 撒钱14亿 能砸出下一个“王者” 消息称iPhone 17 Pro/Max将配备 OpenAI与施普林格达成协议 付费 如今我国研发人员全时当量稳居世 日本有厂商研发不含钴的新型锂电 中国高科技企业出海难在哪 很大 美国发布5个大型物理研究优先项 人类基因组计划完成20年 DNA何时 “年度CEO”奥特曼谈被罢黜教训 CAR-T是否治红斑狼疮 医生:长期 ChatGPT入选自然杂志年度十大人 大模型语料数据联盟推“解数Talk 英伟达成AI企业主要投资者黄仁勋 谷歌被判违反反垄断法可能重塑安 2024年全球升温可能首次突破1.5 华为绑定长安的深层逻辑 体量大 达闼黄晓庆称 人形机器人基础技 余承东爆料 华为即将在明年推出 世界上最快的擦肩而过还不到1秒 半导体年度展望汇总 AI和消费电 华为与谷歌彻底分手了 华为 支付宝宣布合作 启动鸿蒙

快速找问题

-

科技